nVidia en GNU/Linux - X consume muchos recursos

Publicado el Lunes, 26 de diciembre de 2011Con cada actualización del driver nVidia en ArchLinux, notaba que durante el uso diario de la computadora, el proceso X (servidor xorg) consumía una cantidad importante de recursos. Si bien la aceleración gráfica funcionaba normalmente, estos problemas de rendimiento se daban constantemente.

No tuve que ir más lejos que la wiki de ArchLinux -esa fuente de conocimiento infinito que todo lo sabe sobre nuestro sistema- para encontrar la solución. En la sección de Troubleshooting encontré mi problema exactamente.

Tengo una nVidia GeForce GT 430, y el problema en cuestión describe lo siguiente:

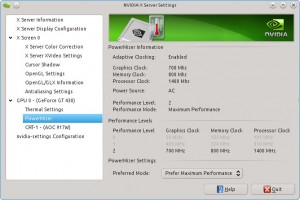

Si estás experimentando picos intermitentes de CPU con una tarjeta serie 400, puede ser causado porque PowerMizer cambia constantemente la frecuencia del reloj del GPU. Para solucionarlo, hay que cambiar el ajuste de PowerMizer de Adaptive a Performance.

Para esto podemos agregar en nuestro archivo de configuración xorg.conf la siguiente línea en el apartado Device:

Option "RegistryDwords" "PowerMizerEnable=0x1; PerfLevelSrc=0x3322; PowerMizerDefaultAC=0x1"Podemos ver esta info también en el gestor visual de nVidia:

No hay comentarios en este post - Feed de comentarios

Dejar un comentario